robots文件(robots文件查看)

- SEO

- 2024-04-10 10:20:21

- 3

dz论坛的robots怎么设置

1、除了设置robots协议之外,还可以在网页代码里面设置。在网页之间加入代码。表示紧致所有搜索引擎抓取网 站和显示快照。

2、首先,我们需要创建一个robots.txt文本文件,然后在文档内设置好代码,告诉搜索引擎我网站的哪些文件你不能访问。然后上传到网站根目录下面,因为当搜索引擎蜘蛛在索引一个网站时,会先爬行查看网站根目录下是否有robots.txt文件。

3、robots.txt必须放置在一个站点的根目录下,而且文件名必须全部小写。

4、打开设置,选择root,把限制抓取更改为允许 robots文件中到底要不要屏蔽JS和css?robots.txt文件中不需要专门屏蔽CSSJS等文件 因为robots.txt只是给搜索引擎蜘蛛爬去做限制的,告诉蜘蛛哪些文件夹或路径不要去爬取。

5、要根据你的网站源代码来确定,屏蔽哪些文件。以dz为例。我的网站是用dz建的。这个是我的robots.txt设置。更具体的,你直接点击,网址,看。谢谢。

6、开启邮箱验证注册,开启发帖验证码,开启防水墙。要是还有一些漏网之鱼,就手动删除吧。

什么是robots.txt文件

1、蜘蛛在爬去网站页面之前,会先去访问网站根目录下面的一个文件,就是robots.txt。这个文件其实就是给“蜘蛛”的规则,如果没有这个文件,蜘蛛会认为你的网站同意全部抓取网页。

2、robotx.txt是一种用于限制搜索引擎爬虫访问网站的文件。通常,网站管理员可以将不希望搜索引擎访问的内容,包括网站目录下的文件、HTML文件、CSS文件和JavaScript文件,添加到robotx.txt文件中。

3、robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。Robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

4、可以删掉,这是规定搜索引擎的网页机器人的动作的文件。

robots.txt有什么用

1、大家先了解下robots.txt文件是什么,有什么作用。搜索引擎爬去我们页面的工具叫做搜索引擎机器人,也生动的叫做“蜘蛛”蜘蛛在爬去网站页面之前,会先去访问网站根目录下面的一个文件,就是robots.txt。

2、定义: robots.txt 是存放在站点根目录下的一个纯文本文件,让搜索蜘蛛读取的txt文件,文件名必须是小写的“robots.txt”。

3、可以写入sitemap文件的链接,方便搜索引擎蜘蛛爬行整站内容。尽量少用Allow指令,因为不同的搜索引擎对不同位置的Allow指令会有不同看待。

4、不是必须要写的。robots.txt文件的意义在于屏蔽掉你不想让搜索引擎爬行的页面。如果网站内容比较少,而且没有什么机密的页面,就没有必要做这个屏蔽了。这样搜索引擎就可以爬行全部页面。

5、robots.txt 主要是原来限制和控制搜索引擎抓取的。可以在上面添加sitemap 文件,会有利于搜索引擎索引网页。

6、可以删掉,这是规定搜索引擎的网页机器人的动作的文件。

robots文件怎么设置Robots文件

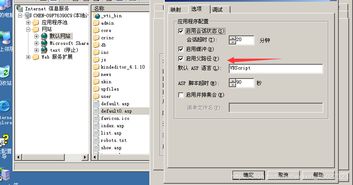

如果你想了解dz论坛(Discuz论坛)的Robots.txt设置,你可以采取以下步骤: 登录dz论坛的后台管理系统。 导航到“论坛设置”或类似的选项。 在设置选项中找到“Robots文件”或相关的设置选项。

网站改版正确使用robots文件的方法是:在改版期间,将robots文件设置为“disallow: /”以阻止搜索引擎访问网站,然后在改版完成后,根据新网站的结构和内容,更新robots文件以允许搜索引擎重新访问网站。

首先我们先来认识一下书写robots时常用到的几个字符 User-agent:写义搜索引擎类型,这里的首字母要大写U,结尾冒号:后要加一个空格键,如 User-agent:* 不带空格,User-agent: * 带空格的。

首先,我们需要创建一个robots.txt文本文件,然后在文档内设置好代码,告诉搜索引擎我网站的哪些文件你不能访问。

WordPress站点默认在浏览器中输入:http://你的域名/robots.txt,会显示如下内容:User-agent:Disallow: /wp-admin/ Disallow: /wp-includes/ 这是由WordPress自动生成的,意思是告诉搜索引擎不要抓取后台程序文件。

另外,当搜索蜘蛛发现不存在robots.txt文件时,会产生一个404错误日志在服务器上,从而增加服务器的负担,因此为站点添加一个robots.txt文件还是很重要的。

robots.txt怎么删除

1、应该是被藏了,找到隐藏文件的功能,取消隐藏再看看有没有。

2、如果你想让搜索引擎收录站点的全部内容,robots.txt 文件是完全可以删除的。推荐用站点程序自带默认的内容就行(可以有效避免收录重复、后台敏感等内容)。

3、可以删掉,这是规定搜索引擎的网页机器人的动作的文件。

4、然后估计在你的站根目录加了机器人搜索拒绝文件(robots)他想害你哦。给你个解决方法。进你的服务器。如果你是独立主机的话。

本文由admin于2024-04-10发表在靑年PHP官网,如有疑问,请联系我们。

本文链接:https://www.qnphp.com/post/287011.html