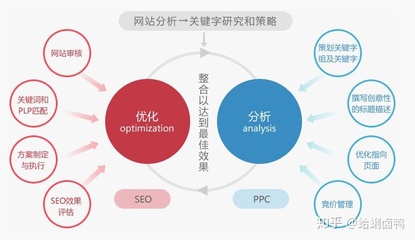

zblog如何不让蜘蛛抓取(如何让蜘蛛抓取指定页面)

- ZBLOG

- 2023-10-24 07:50:10

- 6

怎样限制蜘蛛,让它不爬页面上我规定的链接

在这个例子中,该网站有三个目录对搜索引擎的访问做了限制,即搜索引擎不会访问这三个目录。需要注意的是对每一个目录必须分开声明,而不要写成 “Disallow: /cgi-bin/ /tmp/”。

检查一下网站的robots.txt文件的设置是否合理。百度的设置 在百度搜索引擎优化指南中有明确指出,建议网站不要过大,影响加载速度,不过并没有明确限制说最大多少K。

搜索引擎蜘蛛爬行道我们的网站首先就是抓取这个文件,根据里面的内容来决定对网站文件访问的范围。它能够保护我们的一些文件不暴露在搜索引擎之下,从而有效的控制蜘蛛的爬取路径,为我们站长做好seo创造必要的条件。

这种情况好象只能通过robots.txt设置来解决了,当然对于几个主要的搜索引擎蜘蛛与一淘蜘蛛你可以允许它们访问,但可以通过robots.txt设置禁止其访问一些链接太多,意义不大的页面。好象目前这是最好的解决方法。

并且这个页面包含你的域名 ,这不是一个超链接,但是只有百度收录了我写的这篇文章的页面,那么蜘蛛是会把这个域名列入它的数据库的,然后也会爬取。

如何设置让网站禁止被爬虫收录?

通过 robots.txt 文件屏蔽,可以说 robots.txt 文件是最重要的一种渠道(能和搜索引擎建立直接对话)。通过 meta tag 屏蔽,在所有的网页头部文件添加,添加如下语句:。

要确保网站某些目录或页面不被收录,需要正确使用 robots 文件或Meta Robots 标签来实现网站的禁止收录机制。

基于程序本身去防止爬取:作为爬虫程序,爬取行为是对页面的源文件爬取,如爬取静态页面的html代码,可以用jquery去模仿写html,这种方法伪装的页面就很难被爬取了,不过这种方法对程序员的要求很高。

这样会影响到网站的优化。robots.txt设置 禁止搜索引擎抓取网站的无关页面,禁止蜘蛛爬虫进入到网站。这些就是网站上线前必不可少的准备工作,只有经过了层层检测,网站才能正式上线,这样才对网站顺利的运行下去。

网站栏目的标题一般设置是”栏目名称-品牌词“,不需要做多余的描述。一是因为内页的权重值本身就不高,布局多个关键词是非常不合理的。二是因为简洁的栏目名称能够使用户一眼就能看出这个栏目是干什么的,有利于用户体验。

怎么才能让蜘蛛不抓取整个网站

1、屏蔽主流搜索引擎爬虫(蜘蛛)抓取/索引/收录网页的几种思路。是整站屏蔽,而且是尽可能的屏蔽掉所有主流搜索引擎的爬虫。通过robots.txt文件屏蔽,可以说robots.txt文件是最重要的一种渠道(能和搜索引擎建立直接对话)。

2、总结起来,每个网站的难度都不一样,99%数据是可以抓取到的。百度就是国内最大的爬虫,所以想要完全禁止的,除非服务器关了,数据删了。否则要采集的手段太多了,无外乎就是出于成本上的考虑。

3、robots 文件 搜索引擎蜘蛛访问网站时,会先查看网站根目录下有没有一个命名为 robots.txt 的纯文本文件,它的主要作用是制定搜索引擎抓取或者禁止网站的某些内容。

4、登陆百度自己的“百度快照”帖吧和“百度投诉”帖吧,发个帖子,表明删除网页收录网站快照的原因,当百度管理人员,看到会给予处理。

如何阻止坏蜘蛛机器人采集网站数据

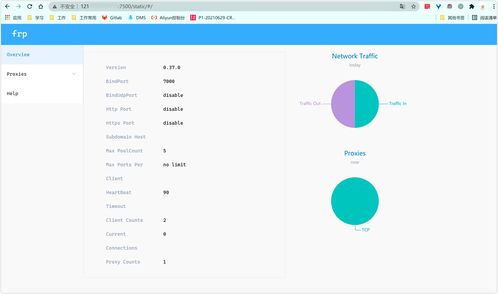

Robots 禁封 Robots 协议(也称为爬虫协议、机器人协议等)的全称是 “网络爬虫排除标准”(Robots Exclusion Protocol),用来告诉搜索引擎、爬虫哪些页面可以抓取,哪些页面不能抓取。

当一个搜索机器人访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果找到,搜索机器人就会按照该文件中的内容来确定访问的范围,如果该文件不存在,那么搜索机器人就沿着链接抓取。

当一个搜索机器人(有的叫搜索蜘蛛)访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,那么搜索机器人就沿着链接抓取。

所有的信息都在存在数据库中的,百度是没办法查看的,当然它肯定有办法进去的。你可以设置robot.txt文件,把后台目录设置禁止机器人访问。

机器人标签robots.txt允许一些搜索引擎进入网站内部,但是它并不能保证具体某个页面会不会被抓取和索引。除非出于SEO的原因,否则只有当确实有必要或者在站点上有需要屏蔽的robots时robots.txt才确实值得使用。

适用网站:对搜索引擎依赖度不高的网站,还有,采集你的人不懂脚本知识。采集器会怎么做:应该说采集者会怎么做,他反正都要分析你的网页代码,顺便分析你的分页脚本,花不了多少额外时间。

网站怎样屏蔽某些蜘蛛过来抓取

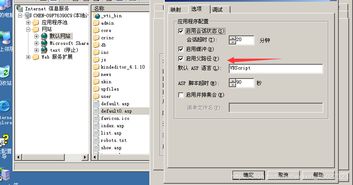

1、在网站的根目录里面,放入robots.txt文件,这样就可以屏蔽蜘蛛的爬取,不过在文件里面要放入你不想让蜘蛛爬取的地方。

2、robots 文件 搜索引擎蜘蛛访问网站时,会先查看网站根目录下有没有一个命名为 robots.txt 的纯文本文件,它的主要作用是制定搜索引擎抓取或者禁止网站的某些内容。

3、网站建设好了,当然是希望网页被搜索引擎收录的越多越好,但有时候我们也会碰到网站不需要被搜索引擎收录的情况。

4、当然,Robots.txt只是一个协议,如果网络蜘蛛的设计者不遵循这个协议,网站管理员也无法阻止网络蜘蛛对于某些页面的访问,但一般的网络蜘蛛都会遵循这些协议,而且网站管理员还可以通过其它方式来拒绝网络蜘蛛对某些网页的抓取。

5、文件的内容如下: 禁止所有搜索引擎访问网站的任何部分 User-agent: * Disallow: / 大家知道为什么要创建一个robots.txt的文件吗,也许有很多的都知道建立这个文件就可以屏蔽蜘蛛的访问,不让搜索引擎抓取到自己的网站。

6、登陆百度自己的“百度快照”帖吧和“百度投诉”帖吧,发个帖子,表明删除网页收录网站快照的原因,当百度管理人员,看到会给予处理。

巧用网站禁止收录机制屏蔽蜘蛛抓取页面

1、要确保网站某些目录或页面不被收录,需要正确使用 robots 文件或Meta Robots 标签来实现网站的禁止收录机制。

2、方法一: 第一种方法需要我们使用robots.txt屏蔽百度蜘蛛抓取下图所示页面。 屏蔽效果如下图所示: 除此以外,我们也可以通过使用robotsMeta标签,屏蔽搜索引擎抓取,在头部加入下图红框所圈代码即可。

3、网站建设好了,当然是希望网页被搜索引擎收录的越多越好,但有时候我们也会碰到网站不需要被搜索引擎收录的情况。

4、《二》Disallow: 是禁止语法,用来定义禁止蜘蛛爬取的页面或者目录。

本文由admin于2023-10-24发表在靑年PHP官网,如有疑问,请联系我们。

本文链接:https://www.qnphp.com/post/243743.html