服务器防采集(采集服务器作用)

- 服务器

- 2022-12-19 17:49:56

- 13

本篇文章给大家谈谈服务器防采集,以及采集服务器作用对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:

php抓取数据

你这样抓别人肯定不让你采集了,这是采集措施吧。你要用专业工具就可以应对常见的防采集措施,试试八爪鱼采集器,我自己测抓几万页面也没问题,还能云采集加速的。

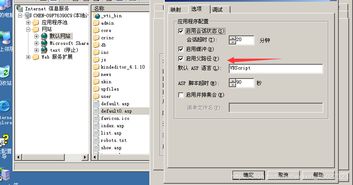

如何使用MYIIS-VIF来限制和防采集功能 让你的站点少点负担

如何用MYIIS-VIF限制和防采集功能

可以确定的是,这可以让你的站点减少负担。对服务器做一些限制有时候也是必须的,资源的被占用,被滥用,你都无法控制。所以,得有这样的举措来控制。

在WEB上面,MYIIS-VIF可以做到很多限制来防止采集。特别是有些文章站点,除开可以被蜘蛛采集以外(数据通道)。让我们看看,我们可以限制些什么?

点击“限制与防采集”—”添加”功能:

1. 禁止使用网络蚂蚁:

现在网络蚂蚁用的真的少了。这个产品其实很不错的。当时用的时候还没有迅雷。

2.禁止使用一切下载工具:

好的,这下就用IE或者浏览器下载吧。

3.禁止使用多线程下载同时禁止断点续传:

插件也别想多线下载了,全世界安静了。这保证了你的原始服务器始终是小流量的,让那些大公司的分流服务器为你工作吧。

4.限制火车头采集和全部.net程序采集:

火车头是个很不错的采集工具,很多采集者都喜欢用它,但它毕竟耗费对方服务器资源。还是向上面那样,让全世界清静点吧。

5.防止flash程序被采集,保护swf文件:

有些站点上大多数是以swf为主的。swf被采集,肯定耗费服务器资源。防止被采集,还是有这个需求的。

以上5点,可以被绕过,但需要点时间去折腾,欢迎广大黑帽子来绕,白帽子来讨论。

高级设置:

这个有点意思,您可以根据抓包的结果,将一些特殊的头放到这里来,如果发现cookies里有特殊的东西,或者提交上来的头有特殊的字符就可以屏蔽。我们以前用这个办法成功屏蔽了一种特殊的CC攻击,估计大部分防火墙(包括CDN防火墙)还不知道吧。聪明的你,如果可以经常抓包,你肯定会有所发现的。来吧,加入MYIIS-VIF的世界,少年。

下面,那个框框的勾选更厉害了。如果有违反这个规则的,将直接一次性锁定ip地址。如果启动ip锁定,在驱动拦截里。还记得我们之前的教程里有提到的。VIF很简单,你一看就会。

ASP与PHP如何防采集?

最常用的防采集方法:1.每个文章的命名不要有任何规律,比如你的文章是%=id%.htm的话,请在前面或后面生成个日期,如:20070911-1234.htm,前面的就是日期了,这样对采集新手来说是非常有效的。2.不要把所有的文章都放在一个目录下,你可以利用日期生成不同的目录名。3.不要所有的文章都用一个模板,制作尽量多的模板,添文章的时候可有选要用哪个模板,一般采集者的采集程序是有针对性的,他在采集前会对你的页面进行分析,如果你所有的页面排版无规律可寻,那么我想他就会放弃了。以上三种方法能防住初级采集的,但是对高手来说没什么用。

下面三种方法用限制采集人的IP或SESSION的方法来达到防采集的目的。防采集方法一:(ASP代码):以下为引用的内容:

%

Dim AppealNum,AppealCount

AppealNum=10 '同一IP60秒内请求限制10次

AppealCount=Request.Cookies("AppealCount")

If AppealCount="" Then

response.Cookies("AppealCount")=1

AppealCount=1

response.cookies("AppealCount").expires=dateadd("s",60,now())

Else

response.Cookies("AppealCount")=AppealCount+1

response.cookies("AppealCount").expires=dateadd("s",60,now())

End If

if int(AppealCount)int(AppealNum) then

response.write "提醒您:抓取很累,歇一会儿吧!"

response.end

End If

%

防采集第二种方法(ASP):以下为引用的内容:

%

user_agent=Request.ServerVariables("HTTP_USER_AGENT")

http_reffer=Request.ServerVariables("HTTP_REFERER")

server_name=Request.ServerVariables("SERVER_NAME")

'检查当前用户是否是蜘蛛人

function check(user_agent)

allow_agent=split("Baiduspider,Scooter,ia_archiver,Googlebot,FAST-WebCrawler,MSNBOT,Slurp",",")

check_agent=false

for agenti=lbound(allow_agent) to ubound(allow_agent)

if instr(user_agent,allow_agent(agenti))0 then

check_agent=true

exit for

end if

next

check=check_agent

end function

if check(user_agent)=False then

if http_reffer="" or left(http_reffer,len("http://"server_name)+1)"http://"server_name"/" then

%

htmlbody

form action='' name=checkrefer id=checkrefer method=post

/form

script

document.all.checkrefer.action=document.URL;

document.all.checkrefer.submit();

/script

/body/html

%response.end

end if

end if

%

防采集第三种方法:用Persistence为静态页面增加session功能 一般来说,只有服务器端的CGI程序(ASP、PHP、JSP)具有session会话功能,用来保存用户在网站期间(会话)的活动数据信息,而对于数量众多的静态页面(HTML)来说,只能使用客户端的cookies来保存临时活动数据,但对于cookies的操作是个很烦琐的过程,远没有对于session操作那样简便。为此,本文向读者推荐一种在DHTML中的解决方案“Persistence技术”,使得在静态页面中也能使用session会话功能。 Microsoft Internet Explorer 5浏览器和以后的版本都支持使用状态保持(Persistence)技术,让我们能够在当前会话过程中保存一些数据对象到客户端,减少了对服务器的访问请求,充分发挥了客户端计算机的数据处理能力,从而也整体提升了页面显示效率。 Persistence技术有以下几种行为可供调用:· saveFavorite—当页面被添加到收藏夹时保存页面状态和信息

· saveHistory—在当前会话中保存页面状态和信息

· saveSnapshot—当页面被保存到硬盘时,保存页面状态和信息

· userData—在当前会话中用XML格式保存页面状态和信息

Persistence技术打破了以前使用cookies和session的传统,继承了cookies的一些安全策略,同时也增加了存储和管理数据的能力。我们的每个页面有64KB的用户数据存储容量,对于每个站点总计有640KB的存储上限。 Persistence技术存储的数据格式符合XML标准,所以可以使用DOM技术中的getAttribute和setAttribute方法来存取数据。 下面是一个Persistence技术的典型应用,通过对Persistence存储数据的分析,使得静态页面具有验证功能。 实际判断过程是这样的: 1.有三个对象:游客V、导航页面A、内容页面C

2.游客V只能通过导航页面A的链接才能看到内容页面C;

3.如果游客V是通过其它途径来访问内容页面C(比如通过其它网站的超链接、直接在IE地址栏中输入网址访问等),内容页面C将自动提示版权信息,显示空白页。

具体实现步骤: · 在“导航页面”中加入一个STYLE用来定义persistent类,同时加入存储函数fnSave用来授权。 以下为引用的内容:

STYLE

.userData {behavior:url(#default#userdata);}

/STYLE

SCRIPT language=Javascript

function fnSave(){

oPersistDiv.setAttribute("bIsValid","true");

oPersistDiv.save("oXMLStore");

}

/SCRIPT

· 在“导航页面”的body和/body区域中定义一个层用来标识Persistence对象 DIV CLASS=userData ID="oPersistDiv"/DIV · 在“导航页面”的超链接属性中加入一条语句用来调用函数fnSave: a href='redhat2.htm' onmousedown="fnSave()" 接下来,为“内容页面”加入验证功能。 · 在“内容页面”中加入一个STYLE用来定义persistent类,同时加入存储函数fnLoad用来判断合法性。 以下为引用的内容:

STYLE

.userData {behavior:url(#default#userdata);}

/STYLE

SCRIPT

var bPageValid=false;

function fnLoad(){

oPersistDiv.load("oXMLStore");

if((oPersistDiv.getAttribute("bIsValid"))

(oPersistDiv.getAttribute("bIsValid")=="true")){

bPass=true;

}

else{

bPass=false;

}

oPersistDiv.setAttribute("bIsValid","false");

oPersistDiv.save("oXMLStore");

if(bPass==false){

var sError="来源不明,请您通过授权网站访问我们.";

alert(sError);

location.href="about:blank";

}

}

/SCRIPT

· 修改“内容页面”的区域如下:以下为引用的内容:

BODY onload="fnLoad()"

DIV CLASS=userData ID="oPersistDiv"/DIV

***插入以上代码的页面需在同一个文件夹下,否则会出错。

从以上范例可看出,通过persistence的使用,使得普通的静态内容页面具有了session功能,一般的不敏感信息完全可以通过session保存在客户端。 使用多个带有session功能的静态页面可以完成众多复杂任务,如虚拟购物车,高级搜索引擎等。同时,由于将以前服务器端承担的部分session任务转移到客户端,减少了数据交互量,大大降低了服务器的负担。

怎么可以防止网页被抓取 - 技术问答

看你的需求了,可以搞得很复杂,也可以搞得很low。之前是做采集的,算不上大神级别。不过可以说80%以上的H5、网页、app可以搞定。单击和分布式爬虫都弄过。日采集上千万数据的不少。覆盖也比较广,视频、电商、新闻、舆论分析类等等。总结起来,每个网站的难度都不一样,99%数据是可以抓取到的。百度就是国内最大的爬虫,所以想要完全禁止的,除非服务器关了,数据删了。否则要采集的手段太多了,无外乎就是出于成本上的考虑。

反爬虫也是需要付出成本的,包括了体验差导致用户流失,内部用的走内网。给用户用的只能做到减少,如果你的数据很有价值,建议是请一个有实力的技术做一些防护。百度上能回答的基本是有解的。

总结一下:反爬只能防君子,防不了小人,可以加大难度,方法也有很多。不过也只是加大采集成本

关于服务器防采集和采集服务器作用的介绍到此就结束了,不知道你从中找到你需要的信息了吗 ?如果你还想了解更多这方面的信息,记得收藏关注本站。

本文由admin于2022-12-19发表在靑年PHP官网,如有疑问,请联系我们。

本文链接:https://www.qnphp.com/post/118679.html