robots协议是什么(robots协议的解读)

- SEO

- 2024-04-07 10:15:47

- 2

浏览器需要遵守Robots协议吗

robots协议是通用共识,一般来说,大型的、有资质的搜索引擎都会遵守,robots协议是网站所有者不想要公开在网上的内容,是为了保障个人隐私,但是robots协议里规定的内容是可以获取的,只是大家默认遵守该协议,不获取协议内的内容。

robots协议是一种存放于网站根目录下的ASCII编码的文本文件。用于对外宣誓主权,规定按照允许范畴访问网站,有效保护网站的隐私。

有报道说,由于360搜索并不遵守搜索引擎通用的Robots协议,也就是爬虫协议,导致很多网站出于安全和隐私的考虑,不允许搜索引擎抓取的一些内网信息也泄漏在了360搜索上,这些隐私甚至可能包括银行帐号、密码、内部邮件等一些信息。

不过,绝大多数中小网站都需要依靠搜索引擎来增加流量,因此通常并不排斥搜索引擎,也很少使用Robots协议。北京市汉卓律师事务所首席律师赵虎表示,Robots协议是维护互联网世界隐私安全的重要规则。

robots协议

1、Robots是一个英文单词,对英语比较懂的朋友相信都知道,Robots的中文意思是机器人。而我们通常提到的主要是Robots协议,这也是搜索引擎的国际默认公约。

2、Robots简单来说就是搜索引擎和我们网站之间的一个协议,用于定义搜索引擎抓取和禁止的协议。

3、谷歌爬虫是指谷歌搜索引擎使用的网络爬虫程序。谷歌爬虫会自动地访问互联网上的网页,并将这些网页的内容存储在谷歌的数据库中,以供搜索引擎进行索引和搜索。

4、Robots协议是网站出于安全和隐私原因设置的,旨在防止搜索引擎抓取敏感信息。搜索引擎的原理是通过一个爬虫蜘蛛程序,自动收集互联网上的网页,获取相关信息。

5、浏览器需要遵守Robots协议。协议简单理解可以理解成大家共同遵守的一个标准,只要是网页浏览器肯定需要支持最常见的协议,一些不常用的就看各浏览器是否支持了。

robots协议的介绍

1、Robots协议通常被称为是爬虫协议、机器人协议,主要是在搜素引擎中会见到,其本质是网站和搜索引擎爬虫的沟通方式,用来指导搜索引擎更好地抓取网站内容,而不是作为搜索引擎之间互相限制和不正当竞争的工具。

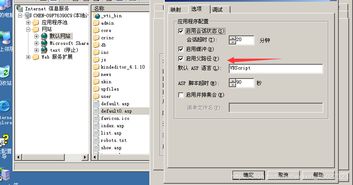

2、Robots协议是一种用于网站管理者通知网络爬虫哪些页面可以被爬取的协议。通过在网站的根目录下放置一个名为robots.txt的文件,网站管理者可以指定哪些页面可以被爬取,哪些页面不可以被爬取。

3、robots是一个协议,是建立在网站根目录下的一个以(robots.txt)结尾的文本文件,对搜索引擎蜘蛛的一种限制指令。

4、robots协议是一个纯文本文件,通常是搜索引擎第一个爬取的文件,搜索引擎该文件了解该网站哪些是所有者不想被收录的内容,进行有选择的爬取和收录。robots协议命名为robots.txt,放在网站的根目录下。

本文由admin于2024-04-07发表在靑年PHP官网,如有疑问,请联系我们。

本文链接:http://www.qnphp.com/post/286135.html