zblog怎么设置robots(zblog怎么设置url)

- ZBLOG

- 2023-07-09 00:00:15

- 13

robots.txt代码设置什么,如何设置它

1、首先,我们需要创建一个robots.txt文本文件,然后在文档内设置好代码,告诉搜索引擎我网站的哪些文件你不能访问。然后上传到网站根目录下面,因为当搜索引擎蜘蛛在索引一个网站时,会先爬行查看网站根目录下是否有robots.txt文件。

2、robots.txt必须放置在一个站点的根目录下,而且文件名必须全部小写。

3、你可以通过FTP找到robots. txt文件,下载到本地修改后再上传。主要是屏蔽不让搜索引擎抓取的文件夹目录,你可以通过FTP查看所有文件夹对照网站栏目来设置,如果还不知道如何操作可以,参考米拓建站官网的robots.txt文件。

4、End robots.txt file User-agent:用于描述搜索引擎蜘蛛的名字,在 Robots.txt 文件中,如果有多条User-agent记录说明有多个搜索引擎蜘蛛会受到该协议的限制,对该文件来说,至少要有一条User-agent记录。

5、一般博客的robots.txt指令设置都是面对所有spider程序,用通配符“*”即可。如果有独立User-agent的指令规则,尽量放在通配“*”User agent规则的上方。

请问zblog的robots.txt这么写正确么?

网络蜘蛛进入一个网站,一般会访问一个特殊的文本文件Robots.txt,这个文件一般放在网站服务器的根目录下。网站管理员可以通过robots.txt来定义哪些目录网络蜘蛛不能访问,或者哪些目录对于某些特定的网络蜘蛛不能访问。

htm是超文本标记Hypertext Markuphtml是超文本标记语言Hypertext Markup Language就后缀而言都是属于静态页面的后缀,但是对于URL而言是有区别的,是两个不同的个体。

如何写robots.txt文件才能集中网站权重?一:什么是robots协议robots协议(也称为爬虫协议、爬虫规则、机器人协议等)也就是robots.txt,网站通过robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不希望被抓取。

robots.txt对搜索引擎来说是门,这扇门是否打开,哪些屋子的门没锁,哪些屋子的门锁了,你说的算。

robots.txt必须放置在一个站点的根目录下,而且文件名必须全部小写。

没有问题的,百度不收录可以从文章质量上找下原因的。

如何设置robots.txt禁止或只允许搜索引擎抓取特定目录?

关于robots.txt一般站长需要注意以下几点:如果你的站点对所有搜索引擎公开,则不用做这个文件或者robots.txt为空就行。必须命名为:robots.txt,都是小写,robot后面加s。robots.txt必须放置在一个站点的根目录下。

你可以通过FTP找到robots. txt文件,下载到本地修改后再上传。主要是屏蔽不让搜索引擎抓取的文件夹目录,你可以通过FTP查看所有文件夹对照网站栏目来设置,如果还不知道如何操作可以,参考米拓建站官网的robots.txt文件。

robots.txt 是百度的禁止收录代码,只要在这个代码后添加你的路径即可,很简单。

例如有些网站的可执行文件目录和临时文件目录不希望被搜索引擎搜索到,那么网站管理员就可以把这些目录定义为拒绝访问目录。

Allow: /tmp 这里定义是允许爬寻tmp的整个目录 Allow: .htm$ 仅允许访问以.htm为后缀的URL。

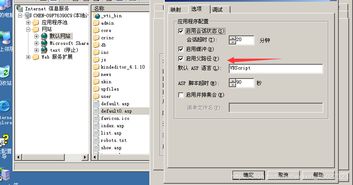

ZBLOG博客被挂马了怎么办?

1、zblog已经很完善了,应该是您的服务器的安全方面不到位,另外先清理掉被挂的马和黑链然后把zblog升级下版本。看一下服务器日志。

2、如果您的网站被挂马了,以下是一些建议: 立即暂时关闭网站:这可以防止挂马病毒的进一步传播,并保护您的客户。 扫描和清除病毒:您可以通过安装杀毒软件扫描并清除恶意软件。

3、准确查找并清除 关于查找被挂马的页面还是有技巧的。我们可以登录服务器或者ftp查看文件的更改时间,如果某个文件的更改时间和被挂马的时间差不多的话,那么久可以确定被挂马的页面很有可能就是这个。

4、网站被挂马,需要处理的方法:立刻清除木马,如果自己公司不熟悉网站程序代码,可以找专业公司来进行处理。服务器及网站整站杀毒。防止木马潜伏在不同地方。

5、对于这种客户网站程序漏洞造成的网站挂马,解决办法一般有两种。一种就是一定要客户选择知名公司开发的网站程序,确保他们能及时更新网站程序,客户也要定期关注程序商的网站,进行程序的更新。

6、简单的说,网页挂马 指的是把一个木马程序上传到一个网站,然后用木马生成器生一个网马,再上到空间里面!再加代码,使得木马在打开网页时运行!被挂马后,当然只能通过查杀手段把他删除了。

robots文档如何设置该屏蔽哪些文件

下面的正确,如果是屏蔽一个文件夹的话,是需要加上斜杠的补充一点,设置好ROBOTS后,蜘蛛还是照常抓取,应该文件生效大概在一个月左右吗,所以不需要急。

robots是网站的和搜索引擎的一个文件协议,你要做的话要把文件写好了上传的网站的根目录,然后再你网站的域名后面加上robots。txt就能查看到了,那些内容就要看你网的那些内容是不想搜索引擎抓取的就屏蔽那些内容。

Robots是一个与搜索引擎的协议,可以屏蔽搜索引擎抓取,在你网站的根目录下新建一个txt文档,文件名是“robots”。在robots.txt文件里设置哪些页面是不允许抓取的即可。

本文由admin于2023-07-09发表在靑年PHP官网,如有疑问,请联系我们。

本文链接:http://www.qnphp.com/post/233302.html